Python在大数据处理中的应用:从Pandas到Spark的无缝过渡

随着数据量的指数级增长,高效处理和分析大数据已成为数据科学领域的核心挑战。Python,凭借其丰富的数据处理库和易用性,成为数据科学家的首选语言。本文将探讨如何利用Python,从轻量级的Pandas库到分布式计算框架Apache Spark,无缝过渡,高效应对大数据挑战。

1. Pandas基础:数据处理的瑞士军刀

Pandas是Python中最受欢迎的数据分析库之一,提供了DataFrame这一灵活的数据结构,专为数据分析任务设计。Pandas擅长于数据清洗、转换、聚合、可视化等操作,适合于处理内存足以容纳的数据集。

数据导入导出:轻松读写多种格式的数据文件,如CSV、Excel、SQL数据库等。

数据清洗:使用功能强大的函数去除重复值、填补缺失值、数据类型转换等。

数据筛选与分组:灵活的索引和切片操作,以及强大的groupby功能,支持复杂的数据分组分析。

2. 面对大数据的挑战

当数据集大小超出单机内存容量时,Pandas的性能会显著下降。这时,转向分布式计算框架如Apache Spark成为必然。

3. Apache Spark简介

Spark是一个用于大规模数据处理的开源集群计算系统,提供内存计算和易于使用的API,支持多种语言,包括Python(通过PySpark库)。Spark的核心优势在于其分布式计算能力,能高效处理海量数据。

RDD(弹性分布式数据集):Spark的基本数据结构,支持并行处理。

DataFrame与DataSet:提供类似于Pandas DataFrame的API,但运行在分布式环境中,适用于大数据分析。

4. 从Pandas到PySpark的过渡

为了让熟悉Pandas的开发者能够快速上手PySpark,以下是一些关键点:

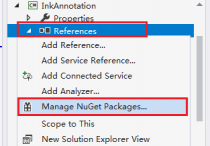

相似的API设计:PySpark DataFrame的设计灵感来源于Pandas,很多操作如

select,filter,groupBy等都非常相似。转换思维:虽然操作相似,但需要考虑分布式环境下的数据分布和计算逻辑,比如数据分区和行动操作(Action)与转换(Transformation)的区别。

资源管理:在Spark中,需要通过配置或SparkSession管理集群资源,如内存分配、并行度等。

5. 实战示例:Pandas到PySpark的代码转换

假设你有一个Pandas DataFrame处理流程,可以逐步转换为PySpark DataFrame操作,利用Spark的分布式计算能力加速处理。

# Pandas 示例 import pandas as pd df_pandas = pd.read_csv('large_dataset.csv') filtered_df = df_pandas[df_pandas['column'] > threshold] aggregated_data = filtered_df.groupby('category').mean() # PySpark 对应转换 from pyspark.sql import SparkSession spark = SparkSession.builder.appName('BigDataAnalysis').getOrCreate() df_spark = spark.read.csv('large_dataset.csv', inferSchema=True, header=True) filtered_df_spark = df_spark.filter(df_spark['column'] > threshold) aggregated_data_spark = filtered_df_spark.groupBy('category').mean() # 展示结果 aggregated_data_spark.show()

结语

Python通过Pandas为数据科学家提供了强大的单机数据分析能力,而Apache Spark及其PySpark接口则为处理超大规模数据集提供了分布式计算解决方案。理解两者之间的相似性和差异,能够帮助数据科学团队在数据处理的规模上实现无缝过渡,从处理GB级数据到TB乃至PB级数据,解锁大数据分析的无限潜能。随着技术的不断演进,掌握这一过渡技能,将是在数据科学领域保持竞争力的关键。

本站发布的内容若侵犯到您的权益,请邮件联系站长删除,我们将及时处理!

从您进入本站开始,已表示您已同意接受本站【免责声明】中的一切条款!

本站大部分下载资源收集于网络,不保证其完整性以及安全性,请下载后自行研究。

本站资源仅供学习和交流使用,版权归原作者所有,请勿商业运营、违法使用和传播!请在下载后24小时之内自觉删除。

若作商业用途,请购买正版,由于未及时购买和付费发生的侵权行为,使用者自行承担,概与本站无关。